Analyser les risques de l'IA

Les risques liés à l’Intelligence Artificielle (Artificial Intelligence) doivent être analysés rigoureusement, notamment pour répondre aux exigences légales, par exemple le prochain règlement européen. Il s’agit aussi pour une entreprise de démontrer son niveau de responsabilité et de durabilité sociétales. Les méthodes d’analyse de risque comme EBIOS RM ou FAIR, les référentiels comme NIST 800-37, ISO 31000, ISO 27005 ou ISACA fournissent un cadre général. Le NIST a développé AI RMF, un référentiel qui fournit des recommandations pour analyser les risques liés à l’Intelligence Artificiel. La définition d’un système utilisant l’IA est issue de l’ISO 22989 (concepts et terminologie relatifs à l’intelligence artificielle). Cette définition de l’IA met en avant les prédictions, recommandations ou décisions en mesure d’influencer des environnements réels ou virtuels.

Les bases

L’approche pour analyser les risques liés aux systèmes IA peut être très différente des applications classiques (qualité de la données, biais des algorithmes, dépendance avec les données d’apprentissage, complexité, utilisation de modèle de préapprentissage, données à caractère personnel, mises à jour fréquentes, difficulté pour organiser des tests…).

Le référentiel comprend deux parties. La première fixe le cadre de l’analyse en donnant des exemples d’événements redoutés suivant les conséquences sur les personnes, l’entreprise ou l’écosystème.

La seconde partie détaille les recommandations autour des axes gouvernance, cartographie, mesure et traitement.

Le référentiel est complété par une annexe (playbook) qui fournit pour chaque item l’objet, des recommandations de mise en œuvre, la documentation et les références disponibles.

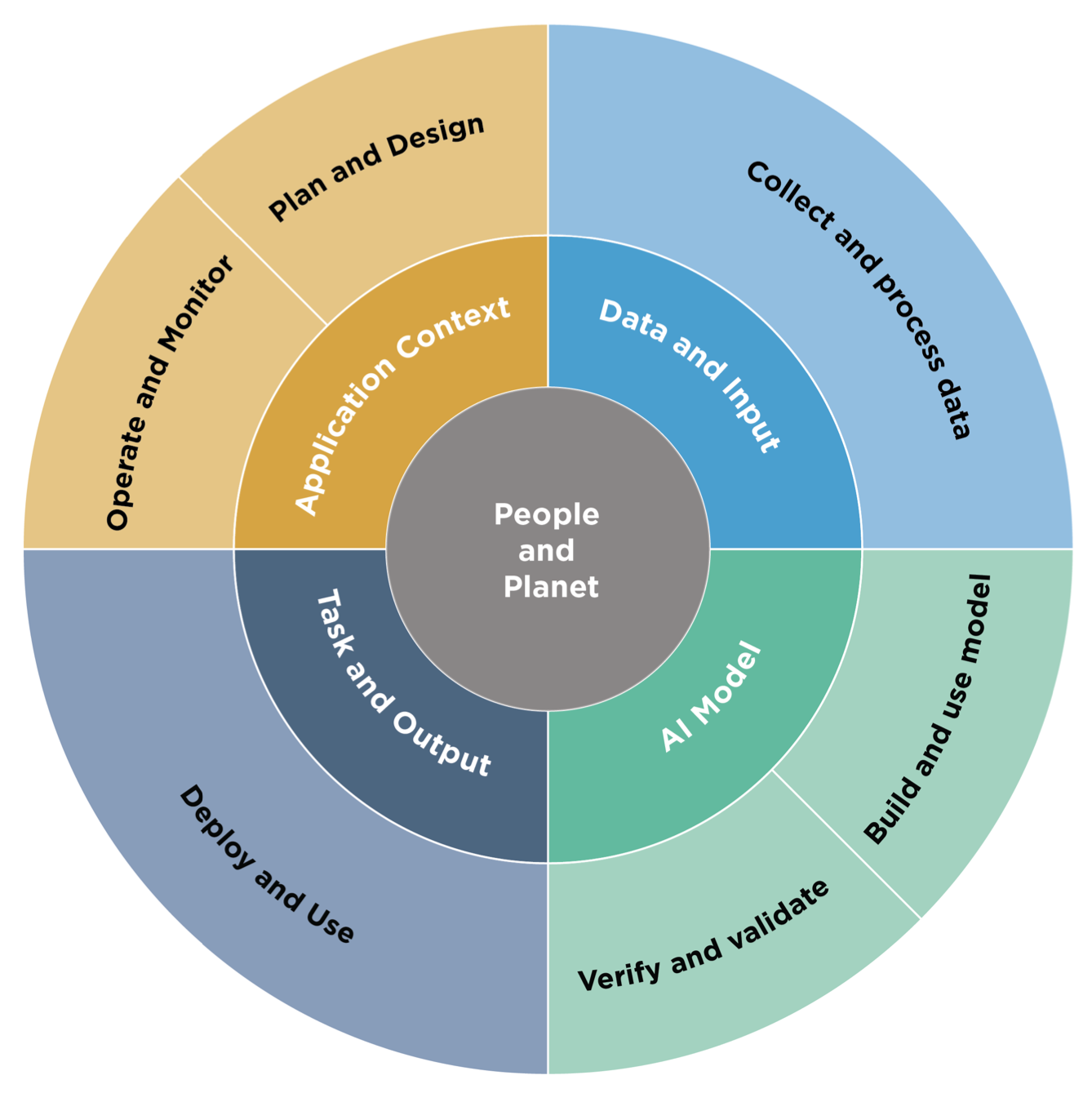

Le référentiel AI RMF se base sur les recommandations de l’OCDE pour classifier les systèmes à base d’IA suivant les dimensions humaines et économiques, les données, les modèle et les tâches attendues.

Le référentiel fait le lien entre cette classification et les phases de développement d’un système IA :

- Planification et conception.

- Collecte et traitement des données.

- Conception et utilisation du modèle.

- Vérification.

- Déploiement.

- Exploitation et supervision.

Source : NIST

Le référentiel AI RMF fixe les caractéristiques suivantes pour qu’un système soit digne de confiance :

- Valide et fiable.

- Sûr, sécurisés et résilient.

- Responsable et transparent

- Explicable et interprétable.

- Respectueux de la vie privée et équitable.

- Non biaisé.

Fonctions

La deuxième partie de AI RMF détaille des recommandations pour gérer les risques liés à l’intelligence artificielle et développer des systèmes dignes de confiance.

Ces recommandations sont détaillées dans le playbook du NIST. La deuxième partie du référentiel est articulée autour des fonctions :

- Gouvernance

- Politique, procédures et processus (7 recommandations)

- Organisation : (3)

- Répartition des ressources (2)

- Culture (3)

- Interactions (2)

- Sous-traitance (2)

- Cartographie

- Contexte (6 recommandations)

- Catégorisation (3)

- Objectifs (5)

- Risques (2)

- Impacts (2)

- Mesure

- Méthode (3 recommandations)

- Caractéristiques de confiance (5)

- Suivi (3

- Retour d’information (3)

- Traitement

- Priorisation (4 recommandations)

- Risques et bénéfices (4)

- Risques et bénéfices liés à la sous-traitance (2)

- Supervision (3)

Comme pour le NIST CSF, un profil de risque correspond à un cas d’utilisation.